Modelos de negocio FLOSS, la universidad, el sector privado y el Estado

Distintos laboratorios de investigación y vinculación de mi facultad del área química y del área computación, junto a algunas empresas de software locales (VATES y otra) y del sector petroquímico (Petroquímica Rio Tercero) están conformando un "Consorcio Asociativo Público Privado (CAPP)" en el marco del programa FSTICS del Ministerio de Ciencia y Tecnología de la Nación, con el fin de desarrollar una plataforma de desarrollo I+D de software para la industria. Para que contextualicemos de que hablamos: el programa estipula un aporte estatal de hasta el 60% para un proyecto de hasta 38 millones de pesos.

Mi participación es minúscula y aledaña: el impulsor de este proyecto es el Dr. Martín Cismondi, director de mi proyecto integrador que se trata de un prototipo del (tipo de) software que se desarrollaría desde esta plataforma.

Cismondi es Phd en ingenieria quimica y sus investigaciones en el campo del equilibrio de fases tienen mucha aplicación en la industria. En particular en el petróleo, donde el impacto que puede tener mejorar el rendimiento de un proceso (por ejemplo de destilación) se mide en millones de morlacos.

Ayer tuve oportunidad de participar de una reunión, sirviendo de una especie de "traductor" entre los quimicos y los informáticos.

Si bien, repito, no tengo voz (mucho menos voto) en nada de lo que allí se resuelva, tengo interés en investigar y transmitir de la manera más clara posible otros modelos de negocio que, por lo que presencié ayer, están lejos de ser tenidos en cuenta. Me refiero, claro, a que, sobre todo (no muy increíblemente) desde la facultad, no se ve más allá de un modelo de negocio de software cerrado de venta por licencia.

Apunto algunas cuestiones sin orden:

El nicho de mercado es bastante acotado: industrias de gran escala

mayormente transnacionales. Separadamente tiene mucha utilidad y

aceptación en centros de investigación académicos.

El nicho de mercado es bastante acotado: industrias de gran escala

mayormente transnacionales. Separadamente tiene mucha utilidad y

aceptación en centros de investigación académicos.

Desde el grupo conformado, no existe conocimiento cabal de las

soluciones de software específicas que ese mercado, el industrial,

demanda. Sí se sabe que el -*expertise-* y el -*know how-* que el

grupo de investigación de Cismondi tiene son el valor diferencial.

Desde el grupo conformado, no existe conocimiento cabal de las

soluciones de software específicas que ese mercado, el industrial,

demanda. Sí se sabe que el -*expertise-* y el -*know how-* que el

grupo de investigación de Cismondi tiene son el valor diferencial.

No existe hoy peso específico suficiente, desde el punto de

vista del producto existente, para competir con las empresas de software

proveedoras de este nicho, sobre todo en los mercados de USA y Europa.

Por ejemplo Aspen Tech.

No existe hoy peso específico suficiente, desde el punto de

vista del producto existente, para competir con las empresas de software

proveedoras de este nicho, sobre todo en los mercados de USA y Europa.

Por ejemplo Aspen Tech.

Es difícil, a priori inimaginable, desarrollar un producto

genérico que satisfaga necesidades de diversos clientes potenciales. La

especifidad de los problemas de cada industria se supone grande.

Es difícil, a priori inimaginable, desarrollar un producto

genérico que satisfaga necesidades de diversos clientes potenciales. La

especifidad de los problemas de cada industria se supone grande.

Preguntas para hacerse ¿cuantos clientes reales existen en el

mercado? ¿qué "llegada" se tiene con ellos? ¿que posibilidades reales de

venderle un software cerrado existen, teniendo en cuenta que no se sabe

cabalmente cuales son sus demandas? Supongiendo que se conoce un

problema específico ¿cuanto sale desarrollar una solución ? ¿se puede

correr el riesgo de desarrollarla sin tener asegurada su

comercialización?

Preguntas para hacerse ¿cuantos clientes reales existen en el

mercado? ¿qué "llegada" se tiene con ellos? ¿que posibilidades reales de

venderle un software cerrado existen, teniendo en cuenta que no se sabe

cabalmente cuales son sus demandas? Supongiendo que se conoce un

problema específico ¿cuanto sale desarrollar una solución ? ¿se puede

correr el riesgo de desarrollarla sin tener asegurada su

comercialización?

Soy un novato en el área negocios con FLOSS (y en negocios, a secas, también) pero lo que se me ocurre viene más o menos por este lado:

1. Generar una estrategia para una fuerte inserción en el ámbito académico internacional

Para esto es indispensable la libre disponibilidad del código fuente de manera que los métodos numérico-científicos sean transparentes, reproducibles y verificables. Ver este post en OpenScience Project.

Para evitar practicas predatorias sobre este trabajo, que alguien cierre y comercialice, hay que orientar a una licencia FLOSS vírica, donde los trabajos derivados mantengan la condicion libre.

De esta manera se apunta a constituir una comunidad tecnologico-científica donde el nucleo de desarrollo se mantendrá en los autores originales pero permitiendo y aprovechando código y feedback de los usuarios.

En esta etapa el beneficio no es a priori monetario y en cambio sí en cuanto a calidad del software, inserción y difusión del/los producto/s, fidelización de usuarios y prestigio del equipo de desarrollo.

2. La repercusión de la masa crítica generada abre la puerta al mercado por las siguientes razones:

Muchos de los académicos que utilicen y formen parte de un "comunidad" alrededor del sofware FLOSS desde las universidades o llevaran su conocimiento a la industria.

Tambien los investigadores dentro de la industria tienen vínculos fluidos con la comunidad científica, sobre todo en estas áreas de investigación de vanguardia de directa aplicabilidad.

El mercado a priori imposible de acceder se puede hacer más permeable: los responsables de investigación demandan la utilización del software en los procesos de la industria o sus labores particulares.

Si el costo para la industria es nulo o bajo y de calidad, hay muchas probabilidades de que sea aceptado.

La ventaja diferencial del cliente es evitar el vendor lock-in. Sin embargo, la ventaja competitiva del equipo de desarrollo original, por su -*know how-* adquirido es insuperable para cualquier potencial competidor.

3. Insertado en el mercado se generan posibilidades de lucro en dos áreas

Customización y extensión del software bajo requerimientos específicos. Entra en el marco de SaaS

Capacitación y entrenamiento a equipos técnicos de la industria y la academia, tanto en el área de aplicación (quimicos) como de desarrollodo de software.

Muchísimo material para leer sobre el tópico hay en este sitio. Yo empezaré en cuanto tenga tiempo. Invito también, de manera enfática, a leer la justificación de que el software desarrollado en el marco de mi proyecto integrador lo libero como Software Libre

Más allá del negocio

Además de lo expuesto se me cruzan cuestionamientos sobre el rol de la universidad y el estado en este escenario.

Como ciudadano y futuro profesional festejo la inversión que en los últimos años el Estado ha realizado para ciencia y tecnología. Apostar a generar valor en áreas tan estrategicas como el software es necesario, y plantearlo desde el punto de vista de fortalecer la industria nacional (pymes) es entonces doblemente valioso.

Pero...

¿son los laboratorios de investigación de las universidades actores que deben generar recursos por sí mismos? ¿A quien pertenece el conocimiento que se produce en la universidad? ¿A quién debe pertenecer? ¿La universidad actual responde a un proyecto de país ? ¿Existe tal cosa? ¿No debiera el Estado, formar parte societaria en los consorcios para los cuales está aportando grandes recursos, además de ser agente regulador? ¿quién y cómo regula la relación e intereses existentes entre los grupos de investigación y el sector privado? ¿no se puede prestar a malversaciones y abuso del sello de la universidad?

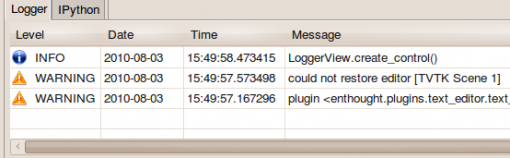

Surge acá un detalle: si los mensajes se generan desde "cualquier parte"

del programa, todas esas "partes" deberían tener referencia de la

instancia del panel/widget de log.

Surge acá un detalle: si los mensajes se generan desde "cualquier parte"

del programa, todas esas "partes" deberían tener referencia de la

instancia del panel/widget de log.